For verdens 430 millioner mennesker som er døve og hørselshemmede, kan kommunikasjon med hørende være vanskelig. Nå har forskere sett på en løsning som bruker maskinlæring for å oversette tegnspråk til tekst eller tale med én gang.

Løsningen kan gjøre dialog enklere, og bidra til at døve og hørselshemmede blir bedre inkludert i samfunnet.

KI foreslo samarbeid med SINTEF

Ideen om å bruke KI-teknologi til å oversette tegnspråk til tekst eller tale, var det Tone Ervik og Pål Rudshavn ved Statped i Trondheim som hadde. De så at KI stadig ble bedre til å oversette fra tale til tekst. Kanskje kunne KI og nye språkmodeller også brukes for å oversette tegnspråk?

– Jeg spurte ChatGPT om hvordan vi kunne komme videre med denne ideen, og den foreslo at vi skulle kontakte SINTEF, så det gjorde vi, sier Tone Ervik.

Tone Ervik og Pål Rudshavn ved Statped hadde ideen om at det burde gå an å bruke KI til å oversette tegn til tekst eller tale. De kontaktet SINTEF for å få hjelp til utvikling av en løsning. Foto: Unni Skoglund

Kombinasjonen av det samfunnsnyttige og det teknologisk utfordrende ved å utvikle et slikt verktøy, gjorde at forskerne umiddelbart tente på ideen.

– Vi i SINTEF så på dette som en fantastisk mulighet. Med de raske fremskrittene innen KI ønsket vi å bruke denne teknologien til noe som faktisk kan gjøre en meningsfull forskjell i samfunnet, forteller Kostas Boletsis og får støtte fra kollega Zia Uddin.

Med støtte fra Stiftelsen Dam startet vi opp prosjektet “KI-drevet Norsk Tegnspråkoversetter” i februar 2024.

Fakta:

I 2009 ble norsk tegnspråk anerkjent som et fullverdig og selvstendig språk, og i Norge er det 16 500 som kommuniserer på tegnspråk. Ifølge WHO forventes det at antallet mennesker med nedsatt hørsel vil øke i årene som kommer. For å bedre kommunikasjonen mellom døve og hørende er det behov for en teknologi som kan lese NTS og oversette det til tekst eller tale. På den måten kan kommunikasjonsgapet mellom NTS-brukere og hørende bli mindre.

Forskere fra SINTEF Digital er i gang med å utvikle en KI-drevet tegnspråkoversetter. Første del av prosjektet hadde 400 000 kroner i budsjett, etter støtte fra Stiftelsen Dam.

Forskerne skisserer prosjektet som tredelt:

- Utvikling av en maskinlærings/KI-basert metodikk for videoanalyse av tegnspråk som kan brukes i norsk tegnspråk, men også i andre tegnspråk.

- En første prototyp som kan lese NTS og transformere det til tekst.

- Prosjektet vil utvikle grunnlaget for et system for sanntids oversetting av NTS til tekst.

I USA er forskere kommet et godt stykke på vei med et verktøy som kan tegnspråktolke i sanntid, ved hjelp av maskinlæring. Men norsk tegnspråk er unikt, så en egen modell må utvikles her til lands. I følge Norges Døveforbund er det 16 500 personer som kommuniserer ved hjelp av tegnspråk.

Engasjerte: Kostas Boletsis og Zia Uddin håper de får anledning til å ta prosjektet “KI-drevet Norsk Tegnspråkoversetter”, videre. – Vi brenner for dette prosjektet, det kan gjøre en forskjell for mange, sier de to forskerne. Foto: Unni Skoglund

Boletsis og Uddin bestemte seg, etter forslag fra Statped, for å starte med å få en datamaskin til å kjenne igjen tegn fra norske tegnspråk (NTS) for tallene 0 til 10 automatisk.

Fakta:

- Forskerne brukte verktøyet MediaPipe fra Google til å hente ut viktig informasjon fra videoer hvor tegnspråklærere fra Statped utfører tegnene.

- MediaPipe er et åpen kildekode-rammeverk fra Google som gjør det enkelt å bruke maskinlæring på mobiler, i nettlesere og innebygde systemer. Det tilbyr ferdige løsninger for blant annet håndsporing, ansiktsgjenkjenning og objektidentifisering.

- Deretter brukte de LSTM-nettverk for å kjenne igjen tegnene. LSTM er forkortelse av Long Short-Term Memory og er en type nevralt nettverk som husker informasjon over tid. Det brukes ofte i språk og tidsserieanalyse fordi det kan fange opp både kortsiktige og langsiktige mønstre.

- Et nevralt nettverk er en datamodell inspirert av hjernen, med lag av «nevroner» som lærer mønstre i data – som å gjenkjenne bilder, språk eller tall.

- Datasettet består av 1059 korte videoklipp.

– Grunnen til at vi fokuserte på tallene 0-10, er at vi måtte starte fra et sted, da norsk tegnspråk skiller seg fra andre tegnspråk. Det kunne vært hvilke som helst andre 11 gester. Vi kan utvikle det videre med tilleggsanalyse, men den grunnleggende tilnærmingen forblir den samme, i større skala med mer komplekse algoritmer, sier Zia Uddin.

Testet systemet i sanntid

Gjennom egen testing har de funnet at systemet de har utviklet for gjenkjenning av norsk tegnspråk viser sterke resultater, med en testnøyaktighet på 95 prosent. SINTEF-forskerne mener dette viser at løsningen takler variasjoner i både tegnstil, hastighet og vinkel.

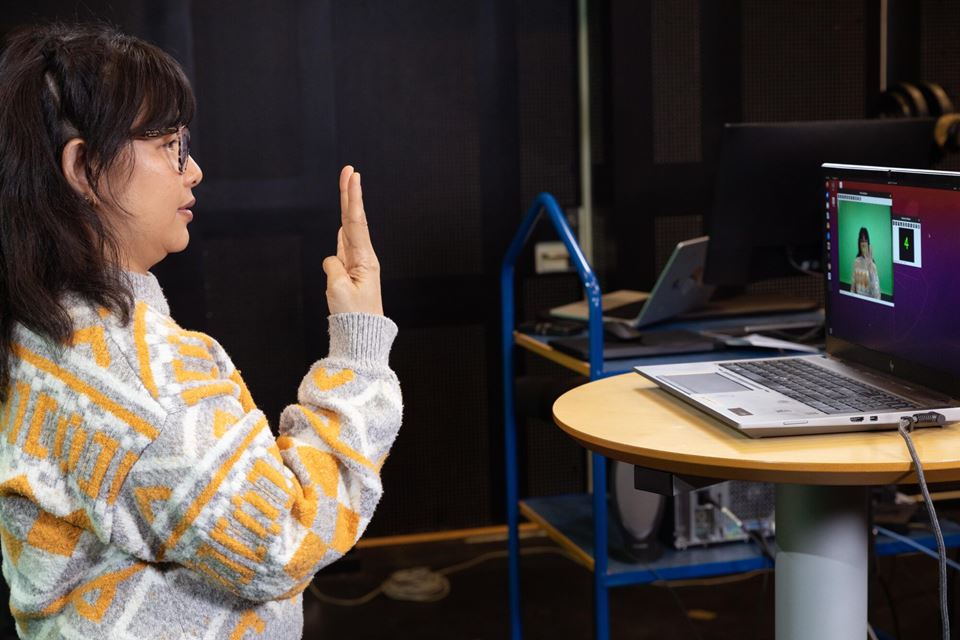

Når vi treffer forskerne, et drøyt år etter oppstarten, er tiden inne for å teste det AI-baserte systemet i sanntid. Tolv tegnspråklige har møtt opp på Statped hvor de en etter en stiller seg foran datamaskinen og viser tegnene mellom 0 og 10. Dataprogrammet bruker hånd- og munnmarkører til å skille mellom tegn med like håndformer, som tegnene 3 og 8. Selv om modellen presterte godt på praksistesten, oppstod noen forvekslinger. Denne informasjonen kan forskerne bruke til å gjøre forbedringer.

– Målet er å utvikle en læringsapp for sanntidsgjenkjenning og evaluering av NTS, der brukere umiddelbar får en oversettelse via en avatar. Det vil hjelpe tegnspråkbrukere å kommunisere med hørende i butikken, hos frisøren, på flyplassen og så videre. Resultatene fra testen i dag peker mot stor fremtidig nytte, sier Kostas Boletsis.

Forskerne sier videreutviklingen bør rette seg mot å utvide ordforrådet, teste i ulike omgivelser (som forskjellig lys, kameravinkler og hastigheter), og bruke flere typer sensordata for å få bedre romlig forståelse.

Målet er en app

– Når omfanget av det vi skal oppnå er så stort, er det naturlig at arbeidet vil ta flere år. Samtidig vil kunstig intelligens utvikle seg parallelt. Kjernen i denne typen prosjekter er data. Vi må utvikle et datasett, et korpus, hvor vi har mye informasjon og mange videoer for hvert tegn som uttrykkes, sier Zia Uddin.

– Da kan vi begynne å bruke KI-modeller i stor skala, trene dem effektivt, og undersøke om de kan håndtere et langt bredere spekter av uttrykk enn det vi har trent på så langt.

Komplekst: Tegnspråkbruker Maarten Vreugdenhil tester tegnspråkoversetteren, mens forskerne følger nøye med. Foto: Unni Skoglund

Forskerne vil nå søke finansiering for å ta prosjektet til neste nivå. Drømmen er en app eller en software som eksempelvis kan installeres på mobilen, og som kan oversette sentrale ord og fraser av tegnspråk simultant.

– Tegnspråk er utrolig viktig for døve og hørselshemmede og med de fremskrittene som gjøres innenfor KI, spesielt innenfor bilde- og videoanalyse, så har vi tro på at vi kan utvikle et verktøy som kan gjøre en forskjell for mange mennesker, sier SINTEF-forsker Zia Uddin.

- Forskningen er publisert i artikkelen Real-Time Norwegian Sign Language Recognition Using MediaPipe and LSTM.